IntelliJ - 在IDEA AI中使用gemini api

前言

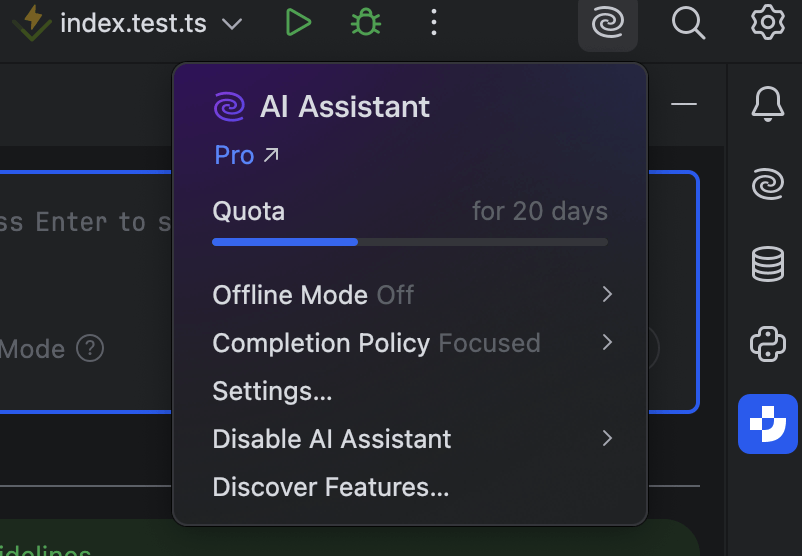

作为IDEA多年的付费用户,对于JB在AI领域的集成总是诟病,不过在2025.1这个版本上看到的希望,我的个人体验因为AI Assistant和Junie两个产品的改进,编程效率提升了非常多。

随之而来的就是quota不够用。不过好在还有其他模型的AK,初步设想是IDEA支持本地的ollama调用,那么使用cloudflare worker做一个ollama的api中转服务。

IDEA中对Ollama的依赖

- /:直接返回 Ollama is running,属于健康检查

- api/tags:返回可用的模型列表

- api/chat:对话聊天

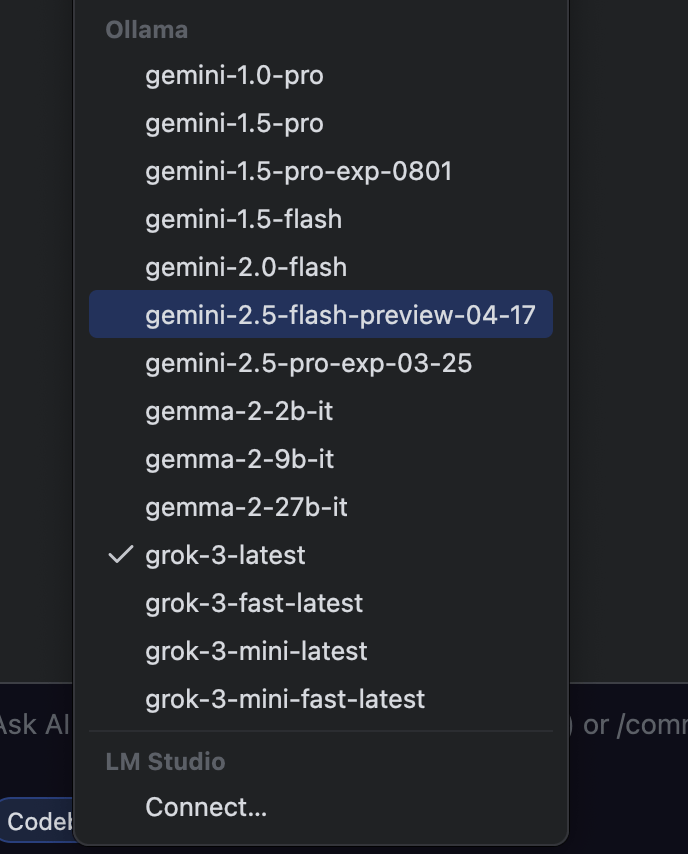

因此只需要针对这三个接口进行处理,好在已经有朋友实现了大部分功能openai-api-proxy,我fork后,在openai风格的基础上增加了ollama风格的api,具体的可以参考项目仓库。

参考github的readme部署后,在IDEA连接,即可愉快的使用自己的API

- 版权声明: 感谢您的阅读,本文由屈定's Blog版权所有。如若转载,请注明出处。

- 文章标题: IntelliJ - 在IDEA AI中使用gemini api

- 文章链接: https://mrdear.cn/posts/work-intellij-ollama